返回

Exo:用你的旧手机搭建AI集群,免费运行大型语言模型!

Star

Forks

Watch

Issues

exo是让你的日常设备,如iPhone、iPad、Android、Mac、Linux等,组成强大的GPU集群,在家运行你自己的AI模型的开源项目。它由exo labs维护,并处于积极的开发阶段。

一、项目介绍

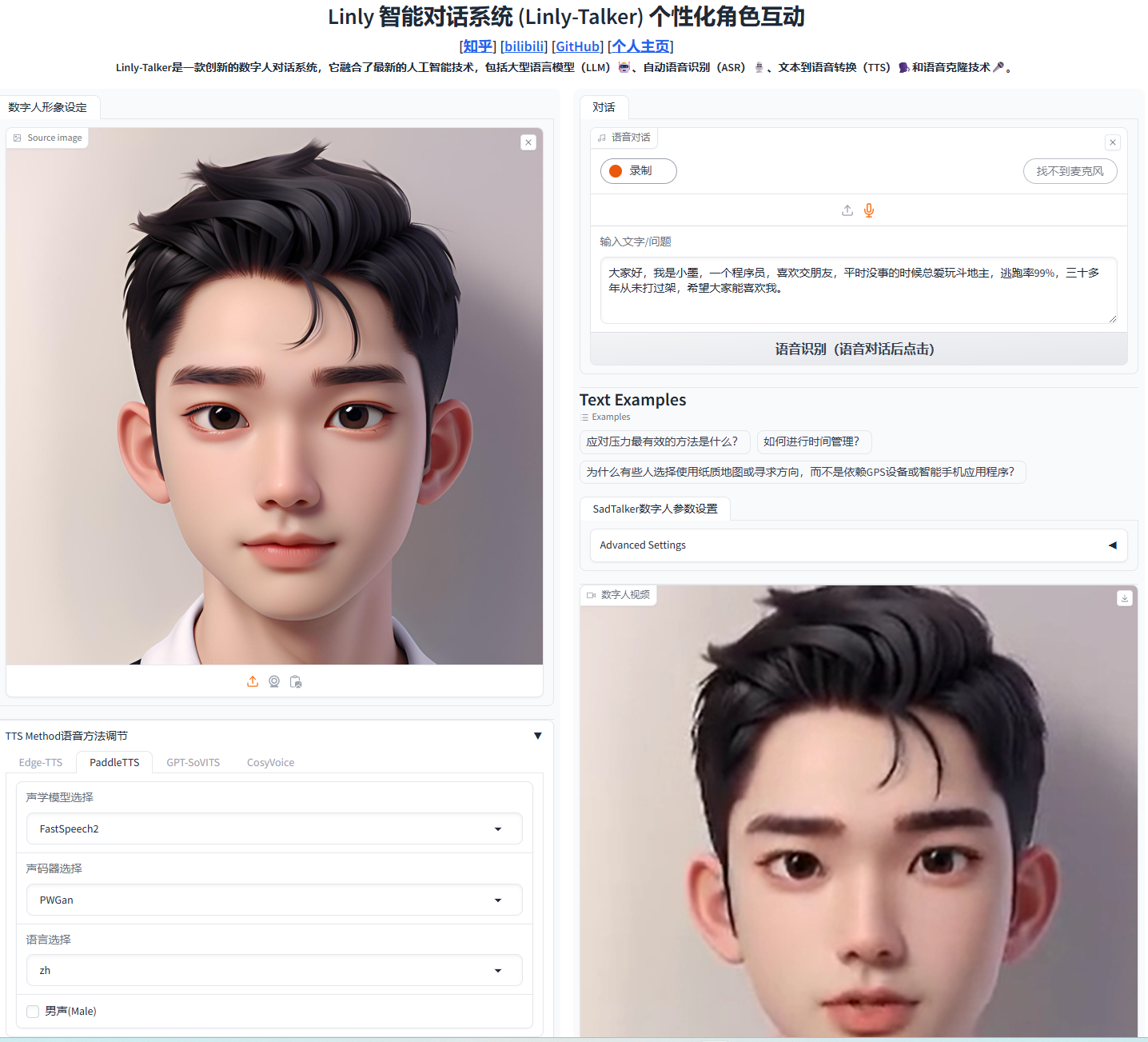

exo致力于让用户无需昂贵的NVIDIA GPU,即可利用现有设备的算力构建分布式AI计算集群。exo支持多种模型,包括LLaMA、Mistral、LlaVA、Qwen和Deepseek,并能够根据网络拓扑和设备资源进行动态的模型划分,以运行比单台设备所能承载的更大的模型。项目提供了类似ChatGPT的API和WebUI,方便用户与模型交互。

二、优势分析

- 易用性: exo的安装和使用非常简单,自动发现和连接设备,无需复杂的配置。用户只需在每台设备上运行

exo命令,即可快速搭建集群。 - 灵活性: 支持异构设备,可以将不同性能的设备(例如高性能GPU、集成GPU甚至CPU)整合到一起,充分利用现有资源。

- 高效性: 动态模型分区策略,根据设备的内存大小分配模型层数,优化资源利用率。

- 兼容性: 提供与ChatGPT兼容的API,方便用户快速集成到现有应用中。

- 去中心化: 采用P2P连接方式,避免了主从架构的瓶颈和单点故障。

三、使用方法

- 安装: 从源码安装是推荐的方式:

git clone https://github.com/exo-explore/exo.git cd exo pip install -e . - 多设备运行: 在每个参与集群的设备上运行

exo命令。exo将自动发现其他设备并组成集群。 - API交互: exo在 http://localhost:52415 提供了ChatGPT兼容的API接口,用户可以使用curl等工具进行交互,示例代码见参考内容。

- 单设备运行: 使用

exo run <模型名称>命令可以在单台设备上运行模型。

四、社区和贡献

exo是一个实验性项目,exo labs团队鼓励用户积极参与测试和反馈问题。项目欢迎社区贡献,并提供了一系列赏金任务。用户可以通过GitHub的Issue和Discord、Telegram、X等渠道与开发者进行沟通交流。

五、总结

exo为用户提供了一种低成本、便捷的方式,利用现有设备构建AI计算集群,运行大型语言模型。项目的易用性、灵活性以及去中心化设计是其主要优势。虽然项目还处于早期阶段,但其发展潜力巨大,未来的功能规划包括支持更多的推理引擎和网络模块,例如PyTorch、llama.cpp以及Radio和Bluetooth连接等。项目的成功依赖于社区的积极参与和贡献。